Вы когда-нибудь создавали мысленный образ человека, которого никогда не видели, основываясь исключительно на его голосе? Искусственный интеллект (ИИ) теперь может делать это, генерируя цифровое изображение лица человека, используя только краткий аудиоклип для справки.

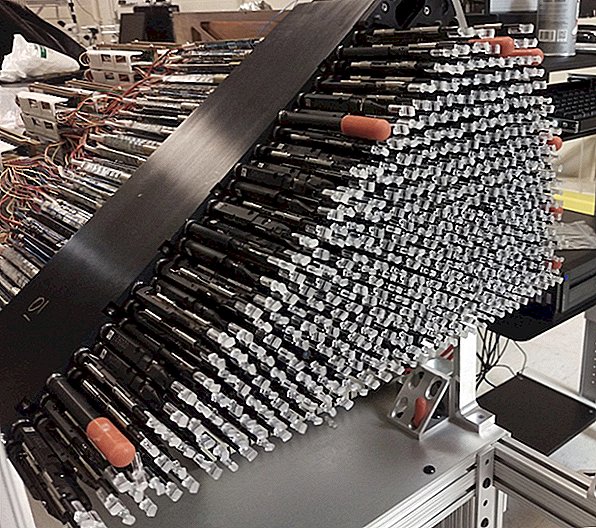

Ученые назвали Speech2Face - нейронную сеть - компьютер, который «мыслит» аналогично человеческому мозгу - обучили миллионам образовательных видеороликов из Интернета, которые показали более 100 000 говорящих людей.

Исследователи написали в новом исследовании, что из этого набора данных Speech2Face выучил ассоциации между голосовыми сигналами и определенными физическими особенностями человеческого лица. Затем ИИ использовал аудиоклип для моделирования фотореалистичного лица, соответствующего голосу.

Результаты были опубликованы в сети 23 мая в препринте jarral arXiv и не были рецензированы.

К счастью, ИИ (пока) не знает точно, как выглядит конкретный человек, основываясь только на его голосе. Авторы исследования сообщают, что нейронная сеть распознает в речи определенные маркеры, указывающие на пол, возраст и этническую принадлежность, а также на общие черты.

«Таким образом, модель будет производить только лица среднего размера», - писали ученые. «Это не будет производить изображения конкретных людей».

ИИ уже показал, что он может создавать необычайно точные человеческие лица, хотя его интерпретации кошек, откровенно говоря, немного пугают.

Лица, сгенерированные Speech2Face - все лицом вперед и с нейтральными выражениями - не точно соответствовали людям, стоящим за голосами. Но, как показывают исследования, изображения обычно отражают правильный возраст, этническую и половую принадлежность людей.

Однако интерпретации алгоритма были далеки от совершенства. Speech2Face продемонстрировал «смешанную производительность» при столкновении с языковыми вариациями. Например, когда ИИ прослушал аудиоклип азиатского человека, говорящего по-китайски, программа создала изображение азиатского лица. Однако, когда один и тот же человек говорил по-английски в другом аудиоклипе, искусственный интеллект сформировал лицо белого человека, сообщили ученые.

Алгоритм также показал гендерную предвзятость, связывая низкие голоса с мужскими лицами и высокие голоса с женскими лицами. Исследователи пишут, что поскольку учебный набор данных представляет собой только обучающие видео с YouTube, он «не в равной степени представляет все население мира».

Другая проблема, связанная с этим набором видеоданных, возникла, когда человек, появившийся в видео на YouTube, был удивлен, узнав, что его сходство было включено в исследование, сообщил Слейт. Ник Салливан, глава отдела криптографии интернет-компании Cloudflare в Сан-Франциско, неожиданно заметил свое лицо в качестве одного из примеров, использованных для обучения Speech2Face (и алгоритм которого довольно приблизительно воспроизвел этот алгоритм).

Салливан не дал согласия на участие в исследовании, но, по словам Сланца, широко распространено мнение, что видео YouTube в этом наборе данных доступны исследователям для использования без получения дополнительных разрешений.